Künstliche Intelligenz

Teufelsteinweg und Kalmtaler Wasserfall

11. April 2024

Der (Alb-)Traum vom Gelddrucken

29. April 2024Auch ich verwende ChatGPT und DeepL. Kürzlich testete ich auch Copilot und Photomath. Die weniger „Digitalaffinen“ unter uns werden jetzt nicht mehr weiterlesen. Tatsache ist,

dass wir der Künstlichen Intelligenz nicht mehr aus dem Weg gehen können.

von Josef Prantl

Die meisten jungen Menschen wissen ganz genau, was „Photomath“ bedeutet. Es handelt sich dabei um eine App auf ihrem Smartphone, die Mathematikaufgaben löst und dabei auch den Rechenweg erklärt. Wie der Name des Programms schon sagt, werden die Aufgaben nicht einmal eingetippt, sondern können mit der Kamerafunktion abfotografiert werden.

Generative Künstliche Intelligenz

„Generativ“ ist auch so ein Begriff, der es in sich hat. Das Wort kommt vom Lateinischen „generare“ und bedeutet so viel wie „erzeugen“, „hervorbringen“. „ChatGPT“ (eigentlich) „Generative pre-trained transformers“ und 2018 von dem US-amerikanischen Unternehmen „Open AI“ erstmals vorgestellt) ist so eine „generative künstliche Intelligenz“. Das Programm kann nämlich eigene Texte, aber auch Bilder, Videos und Musik erzeugen. Vielleicht stammt dieser Text gar nicht von mir, sondern ist von „Chat GPT“ geschrieben?

Das Unternehmen OpenAI hat 2022 ChatGPT für alle zugänglich gemacht, allerdings nur mit Inhalten (gemeint sind Daten) bis September 2021 trainiert und nicht mit dem ganzen Internet verbunden. Die meisten Oberschüler, die heute ihre Hausaufgaben über ChatGPT erledigen, greifen darauf zurück. Denn die KI schreibt Aufsätze, erstellt Referate, berechnet Aufgaben in Sekundenschnelle. Im Februar 2023 hielt der deutsche Abgeordnete Damian Boeselager im Europaparlament eine von ChatGPT geschriebene Rede. Boeselager ließ die Software eine Rede über die Regulierung von Künstlicher Intelligenz in Shakespeare-Englisch schreiben, um die Auswirkungen generativer Sprachmodelle in der Arbeitswelt darzustellen.

Zeitenwende

Traditionelle KI (wie wir sie in unseren Routenplanern oder bei der Gesichtserkennung auf dem Smartphone haben) kann „nur“ bestimmte Aufgaben nach vorgegebenen Regeln (Algorithmen) ausführen. Sie kann weder aus Daten lernen noch sich im Laufe der Zeit verbessern. Die generative KI hingegen kann aus Daten lernen und neue Daten erzeugen. „Machine Learning“, also maschinelles Lernen nennt man den Prozess, bei dem sich ein Computerprogramm an neue Daten anpasst und selbstständig daraus lernt, sodass Erkenntnisse gewonnen und Entwicklungen erkannt werden können. Eine wesentliche Frage stellt sich allerdings dabei: Mit welchen Daten wird die KI gefüttert und wofür soll sie eingesetzt werden? Die neueste Version von ChatGPT kann sogar sprechen. Während bei den Vorgängerversionen Anfragen – man nennt sie in der Fachsprache „Prompts“ – nur schriftlich möglich sind, kann man mit der kostenpflichtigen Version (rund 20 Euro/Monat) von ChatGPT 4 wie mit einem Menschen sprechen, einen dialogischen Austausch führen. Mit „Copilot“ von Microsoft lässt sich über den Menüpunkt „Designer“ jedes erdenkliche Bild erstellen, ein „Cooking Assistent“ hilft beim Kochen und über „Vacation planner“ kann man wie mit einem realen Reiseexperten den nächsten Urlaub organisieren.

Das Internet der Dinge (IoT)

Alexa, Cortana oder Siri sind schon lange bekannt und in viele unserer Wohnstuben eingezogen. Es handelt sich um „digitale Sprachassistentinnen“, die mit dem Internet verbunden per Sprachsteuerung auf Dienste und Informationen zugreifen. Man kann die Funktionen erweitern und diese digitalen Assistentinnen „menschlicher“ machen: So begrüßt Alexa mit einem Kompliment oder einem Witz. Alexa (dahinter steht Amazon) kann auch viele Wissensfragen beantworten. Man spart sich also das Suchen in Wikipedia. Siri von Apple spielt Musikwünsche, stellt die gewünschte Haustemperatur ein oder schaltet den Fernseher aus. Voraussetzung ist, dass alle Geräte miteinander über das Internet verbunden sind. So ist auch das „Internet der Dinge“ zu verstehen, das sogenannte „IoT“. Dem Kürzel begegnet man öfter: „Internet of Things“ steht für eine vernetzte Welt aus „smarten“, d.h. intelligenten Geräten.

Wenn Maschinen Menschen nachahmen

Google ist die wohl bekannteste Antwortmaschine auf alle möglichen Fragen des Alltags. Künstliche Intelligenz kann das aber viel besser. Der maschinelle Online-Übersetzer „DeepL“ zum Beispiel. Es basiert auf neuronalen Netzen. Mit deren Hilfe kann eine Künstliche Intelligenz – im Fall von DeepL – sich für die richtige Übersetzung entscheiden. Nach der Trainingsphase optimieren sich neuronale Netze stetig selbst. Dieses sogenannte „Deep Learning“ wird zum Beispiel auch für Deepfakes eingesetzt. Wenn es um Künstliche Intelligenz geht, dann kommt man an Englisch nicht vorbei. „Deepfakes“ sind Bilder oder Videos, die durch Künstliche Intelligenz so manipuliert wurden, dass man sie von echten Bildern bzw. Aufnahmen nicht mehr unterscheiden kann. Die Foto-Fälschung der KI „Midjourney“ von Papst Franziskus im schneeweißen Mantel ging um die Welt.

Es braucht Regeln

KI bietet immer mehr Möglichkeiten der Manipulation. Man kann einen „Bot“ (ein Roboterprogramm) bauen, der nicht mehr einfach nur eine Nachricht postet, sondern ganz persönlich auf Facebook oder Twitter Menschen anschreibt und sogar auf Antworten reagiert und Unterhaltungen führt. Das geht bis hin zu Fake-Anrufen, bei denen man gezielt eine Stimme generiert, die so klingt wie ein Familienmitglied.

Die Macht von Bildern und die Bedeutung der sozialen Medien spielen gerade in der aktuellen Weltsituation eine große Rolle und können eine immense politische Sprengkraft entwickeln. In diesem Kontext stellt neben herkömmlichen Falschmeldungen das von KI-generiertem Material eine große Gefahr dar. Das alles macht es schwer, Fehlinformation von echten Inhalten zu unterscheiden. Wie missbraucht werden kann, ist noch viel zu wenig bekannt. Es braucht den Willen, sich zu informieren und nicht einfach bequemer Konsument zu sein, zu dem uns die Digitalisierung erzieht.

Desinformation durch KI zu erkennen lernen, vertrauenswürdige Quellen zu nutzen und sich mit dem technischen Fortschritt weiterentwickeln, ist Bildungsauftrag demokratischer Gesellschaften. Ganz im Sinne des Schweizer Dramatikers Friedrich Dürrenmatt, der es in den 1960er Jahren vor dem Hintergrund der atomaren Bedrohung auf den Punkt brachte: „Der Inhalt der Physik geht die Physiker an, die Auswirkungen alle Menschen. Was alle angeht, können nur alle lösen!“

Wie Künstliche Intelligenz unser Leben verändert

Künstliche Intelligenz ist die Technologie der Stunde. Der Algunder Christian Zelger hat Philosophie und Deutsche Philologie studiert, lehrt am Realgymnasium Meran und hat sich in Texten, Vorträgen und Radiosendungen mit kulturgeschichtlichen Themen sowie ethischen Fragen auseinandergesetzt.

Im BAZ-Gespräch nimmt Zelger Stellung zum Thema „Künstliche Intelligenz“.

Christian Zelger

ChatGPT, Copilot, Gemini oder DeepL haben in der letzten Zeit für Aufsehen gesorgt. Aber warum eigentlich?

Christian Zelger: Mit dem Textgenerator ChatGPT, der seit Ende 2022 für jeden zugänglich ist, ist die Künstliche Intelligenz in die Mitte der Gesellschaft vorgedrungen. Es geht nicht mehr um Spezialaufgaben für die Forschung, sondern um alltägliche Arbeiten wie Texte verbessern, kürzen, übersetzen, Fragen beantworten, E-Mails, Bewerbungsschreiben und Hausaufgaben verfassen uvm. Es existieren mittlerweile über tausend solcher Programme mit immer neuen Anwendungsbereichen. Dementsprechend hoch ist das Interesse der Medien und der Nutzer.

Als der Schachcomputer Deep Blue 1996 den Schachweltmeister Garry Kasparov besiegte, war das eine Sensation. Wird Künstliche Intelligenz den Menschen übertreffen?

Das hängt davon ab, wie man Intelligenz definiert. In vielen Bereichen hat KI den Menschen schon überholt, zum Beispiel wenn es darum geht, Muster in großen Datenmengen zu finden, auch in der Sprach- und Bilderkennung, sowie beim Leseverständnis. Das alles gehört aber zur sogenannten „schwachen KI“ – das Lösen von komplexen, aber sehr konkreten Einzelaufgaben. Eine „starke KI“ mit einer dem Menschen vergleichbaren Intelligenz, einem Willen und einem Selbstbewusstsein gibt es noch nicht. Ein Textgenerator z.B. versteht nicht, was er ausgibt; ebenso wenig hat er das Bedürfnis, sich ohne Aufforderung beim Nutzer zu melden.

Wie entsteht eigentlich Künstliche Intelligenz und was unterscheidet sie von gewöhnlichen Maschinen?

Es sind vor allem zwei Merkmale, die wesentlich zu einer KI gehören, einerseits die Fähigkeit zu lernen, d.h. nicht nur einen fest vorgegebenen Programmcode abzuarbeiten, sondern sich aufgrund von „Erfahrungen“ zu entwickeln und zu verbessern; andererseits muss ein solches System mit Wahrscheinlichkeiten, Unsicherheiten und Ungenauigkeiten umgehen können, genau wie wir Menschen. Schreibe ich von „Sprahcerkhennung“, dann würde ein traditionelles Programm nichts damit anfangen können, im Gegensatz zu einem Menschen oder einer KI.

Was halten Sie von dem beliebten Narrativ, dass sich Maschinen gegen ihre Schöpfer wenden, wenn sie einmal schlau genug sind?

Nicht viel. Sieht man sich die Geschichte und vor allem frühere langfristige Voraussagen von Entwicklungen an, dann sollte man vorsichtig mit solchen Prophezeiungen sein. Ich habe eher Sorge, dass wir uns als Menschen zu sehr in der Künstlichkeit verlieren.

Was ist also bedenklich an ChatGPT und ähnlicher generativer Künstlicher Intelligenz?

Bedenklich sind für mich diese Dienste immer dort, wo die persönliche Entwicklung von Menschen behindert wird. Es spricht z. B. nichts gegen eine Anwendung zur Unterstützung bei medizinischen Diagnosen oder zur Verbesserung von Produktionsabläufen. Wo aber das eigene Wachsen an Herausforderungen nicht mehr möglich ist oder Leistungen vorgetäuscht werden, hat KI nichts zu suchen. Welcher Personalchef möchte schon ein perfekt geschriebenes Motivationsschreiben eines Bewerbers lesen, das dieser gar nicht selbst verfasst hat? Das Problem liegt nicht darin, dass nicht auch bisher getrickst wurde, sondern wie einfach, schnell und gut das nun möglich ist.

Welche ethischen Fragen stellen sich in diesem Zusammenhang, etwa wenn es um den hohen Energieverbrauch geht oder um die Würde des Menschen?

Die ethisch problematischen Aspekte von KI sind tatsächlich nicht wenige. Der hohe Wasser- und Stromverbrauch ist einer davon, aber auch das Verwenden von urheberrechtlich geschützten Werken und das Ausbeuten von afrikanischen Klickarbeitern zum Trainieren von KI-Modellen oder die Frage, wer Verantwortung übernimmt, wenn eine KI Entscheidungen treffen soll, z.B. bei Finanztransaktionen, beim autonomen Fahren oder, wesentlich erschreckender, bei im Krieg eingesetzten Kampfdrohnen.

Die EU hat inzwischen ein ganzes Paket an Regulierungen erlassen, was KI betrifft. Viele kritisieren das, weil Europa so ins Hintertreffen gelangt. Zurecht?

Das ist ein Dilemma und eine Gratwanderung zugleich. Ginge es nur um ökonomische Belange und Wettbewerb, bräuchte es kaum Regulierung. Natürlich soll auch Europa bei der Entwicklung von KI-Modellen eine Rolle spielen. Wir sollten aber bedenken, dass trotz herrschender Goldgräberstimmung der Mensch, seine Rechte und seine Würde nicht ins Hintertreffen gelangen dürfen. Es ist deshalb anzuerkennen, dass die EU mit ihrem „AI Act“ hier eine Vorreiterrolle einnimmt und trotz des enormen Drucks von Seiten der KI-Lobby eine Regulierung zur Risikominimierung, zu mehr Rechtsschutz und Transparenz angegangen ist. Ich hoffe, dass der europäische Weg langfristig erfolgreich sein wird.

Die Sorge, dass Künstliche Intelligenz die Arbeitswelt bedrohe bzw. die Befürchtung, den Arbeitsplatz an einen Computer, Roboter oder eine KI zu verlieren, ist aber da. Wo konkret sehen Sie diese Sorge berechtigt?

Es ist fast schon ironisch. Lange Zeit hat man geglaubt, dass uns Roboter lästige praktische Arbeiten abnehmen werden und dass Berufe, die damit zu tun haben, aussterben werden. Und nun kommt man drauf, dass Übersetzer, Programmierer, Finanzmathematiker, Kundenservice-Mitarbeiter und Webdesigner zu den bedrohten Berufskategorien gehören. Tätigkeiten hingegen, die besonderes handwerkliches Geschick, echte Kreativität oder Empathie verlangen, werden auf absehbare Zeit nicht ersetzbar sein.

Künstliche Intelligenz hat Auswirkungen auf die Demokratie sowie unser Selbst- und Weltbild. Stimmt das?

Ja, durchaus. Die größte Gefahr sehe ich in den Deepfakes. Darunter versteht man von einer KI generierte Bilder, Videos und Audioaufnahmen, die kaum von echten zu unterscheiden sind. Es wird – in der Datenflut, der wir ausgesetzt sind – immer schwieriger werden, Realität von Fiktion zu unterscheiden. Es fehlt Zeit, Wissen und vielleicht auch der Wille dazu. Besonders heikel wird dies, wenn es sich um politische Inhalte handelt. Das Argumentieren und das Verhandeln von Positionen gehören aber wesentlich zu einer Demokratie. Wie soll dies geschehen, wenn man nicht mehr weiß, was wahr ist?

Zum Schluss: Wie gehen Sie persönlich mit Künstlicher Intelligenz um?

Ich beschäftige mich intensiv mit den Funktionen verschiedener KI-Modelle und teste, was möglich ist, um mir ein Bild zu machen und die Technologie besser zu verstehen. Da ich aber nichts lesen möchte, was eine Maschine, die vorgibt ein Mensch zu sein, an mich richtet, so werde ich auch weiterhin meine Texte allein schreiben.

Sich aktiv informieren und nicht bequemer Konsument bleiben

Anton Walder und Valentin Umlauft vom Zentrum für Informationskompetenz an der Universitäts- und Landesbibliothek Tirol referierten auf der 43. Jahreshauptversammlung des Bibliotheksverbandes Südtirol über Chancen und Risiken der Künstlichen Intelligenz. Am Herzen liegt den Nordtirolern, dass möglichst alle Menschen Zugang zu gesicherten und fundierten Informationen haben, die Grundlage für eine demokratische Gesellschaft. Die BAZ sprach mit ihnen.

Anton Walder und Valentin Umlauft

Ein Bestseller zur Künstlichen Intelligenz hat den Titel „Das Ende der Demokratie – wie die künstliche Intelligenz die Politik übernimmt und uns entmündigt“. Zurecht?

Anton Walder/Valentin Umlauft: Ja und nein. Dass eine so mächtige Technologie Ängste erzeugt, ist verständlich. Seit ChatGPT und die sogenannte Generative Künstliche Intelligenz die breite Öffentlichkeit erreicht hat, ist die ganze Problematik erst so richtig ins Bewusstsein gerückt. Dabei wird KI schon lange eingesetzt, etwa bei der Gesichtserkennung, in den Sozialen Medien oder bei unseren Routenplanern. Grundsätzlich ist jede KI ein Modell, das Algorithmen beinhaltet, deren Berechnungen aber mit Trainingsdaten festgelegt werden; im eigentlichen Sinn eine gigantische statistische Berechnungsmaschine. Und das ist auch der Knackpunkt, denn das, was dann herauskommt, hängt mit den Daten zusammen, die zum Training der KI verwendet werden. Fehler, Einseitigkeiten und Verzerrungen in den Trainingsdaten werden weitergegeben. Es ist also eine vom Menschen getroffene Entscheidungssache, welche Daten verwendet werden, aber auch wo Künstliche Intelligenz eingesetzt wird. KI kann in bestimmten Einsatzgebieten sehr gefährlich werden. Es ist also eine ethische Frage, wie man sie einsetzt. Problematisch ist, dass derzeit nur große private Konzerne in der Entwicklung mitmischen, und die haben wohl mehr Eigeninteressen im Sinn denn das Gemeinwohl. Dabei geben wir ihnen leichtfertig unsere Daten weiter. Demokratie gefährdendes Potential hat KI, wenn in den Sozialen Medien massenhaft Desinformation eingespeist wird und so Desinformationsblasen gebildet werden.

Künstliche Intelligenz betrifft auch die Bibliothekswelt, die gerade einen Wandel durchlebt, bei dem wir noch nicht genau wissen, wohin die Reise geht. Haben Bibliotheken im wörtlichen Sinn ausgedient?

Nein, sie werden wichtiger denn je. Bibliotheken sind ein Gegenentwurf zu Fake News und Desinformation, weil sie unabhängige, nichtparteiische, also neutrale Anbieter sind und niederschwellig Zugang zu gesichertem Wissen anbieten. In einer digitalen Welt erhält die Bibliothek als Ort des Lesens und Lernens, wo das Blättern in Büchern haptisch möglich ist, besondere Wertschätzung. Bibliotheken werden noch stärker zu Zentren, wo Recherche- und Informationskompetenzen vermittelt werden. Bibliotheken vermitteln informationskompetentes Verhalten und geben den Menschen Werkzeuge in die Hand, Rechercheergebnisse zu bewerten und vertrauenswürdige von nicht vertrauenswürdigen Quellen zu unterscheiden.

Kann Künstliche Intelligenz den Zugang zu Wissensbeständen erweitern, erleichtern und demokratisieren – und somit entscheidend für gesicherte und fundierte Informationen beitragen?

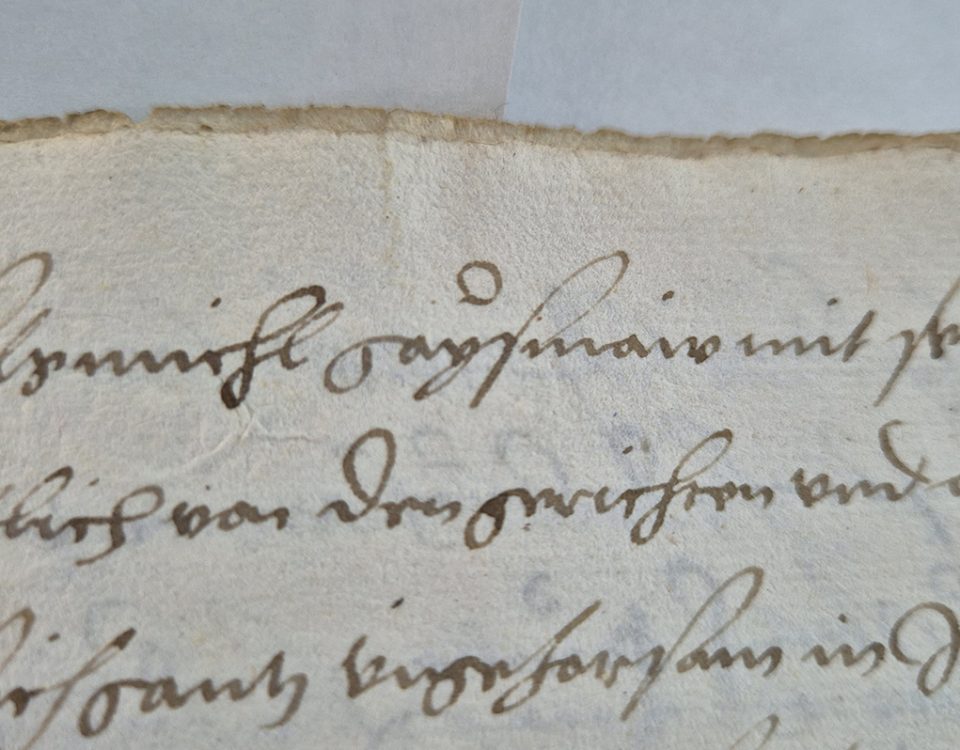

Nein, KI kann das nicht leisten, ist eher eine Gefahr für gesichertes Wissen, wenn man etwa an KI-generierte Inhalte denkt. Die Frage zielt in Richtung Digitalisierung. Diese kann entscheidend dazu beitragen, dass Wissen breit und offen verfügbar ist. Digitalisierung kann den Zugang erleichtern, da verschlossene Bestände online verfügbar gemacht werden können. Gute Beispiele sind hier die digitalisierten Handschriften, beispielsweise aus dem Kloster Neustift. Weltweit digitalisieren Bibliotheken analoge Inhalt und machen diese überall verfügbar; die Tessmann-Bibliothek hat viele Zeitungen digitalisiert, die vielfach sogar im Volltext frei verfügbar zu lesen sind.

Ist der ganze Hype um Künstliche Intelligenz nicht übertrieben?

Die Erwartungshaltungen an die KI sind derzeit sehr übertrieben. Im Grunde ist es aber gut, dass die Macht von KI-Modellen in einer breiten Öffentlichkeit erfahrbar geworden ist, jeder kann Chat GP ausprobieren. Es ist wichtig, dass das Thema KI in der Gesellschaft angekommen ist, da hier der Diskurs geschehen muss, wie man damit umgeht, damit letztlich eingesetzte Anwendungen nicht einer liberalen Demokratie entgegenwirken, etwa wenn KI für die Überwachung, die politische Kontrolle und die nationale Sicherheit eingesetzt wird. Den Menschen auf einen steuerbaren Datenhaufen zu reduzieren – das wäre eine fundamentale Änderung des Menschenbilds, auf dem unsere Demokratien beruhen.